Malgré la multitude d’articles sur le sujet, l’analyse de logs reste encore un peu vague et peu démocratisée en référencement naturel. Pourtant, les résultats qui en découlent sont souvent très intéressants.

L’analyse de logs est souvent présentée comme un aspect très technique de notre métier. Les logs serveurs brutes sont indigestes et peuvent rebuter les personnes moins à l’aise avec les lignes de code. Heureusement, des outils comme OnCrawl permettent de simplifier la lecture des logs SEO et d’envisager des actions efficaces pour pallier certains problèmes critiques en référencement naturel.

Contrairement à ce qu’il se dit sur la toile ou en conférence, l’analyse de logs n’est pas réservée aux sites à forte volumétrie. Qu’elle que soit la taille de votre site, l’analyse des logs peut apporter des réponses directes aux problèmes SEO rencontrés sur votre site web.

À quoi sert vraiment l’analyse de Logs ?

Chaque fois qu’un utilisateur ou qu’un robot visite votre site web, une petite ligne de logs va être écrite dans un fichier sur le serveur (Log File). Une visite peut venir d’un visiteur sur mobile, tablette, PC ou d’un robot comme celui de Google (Google Bot).

L’analyse de logs va donc permettre d’identifier le trafic SEO et d’observer les passages des robots de Google sur votre site. L’analyse de logs est donc utile pour réaliser des audits SEO, pour débloquer des situations d’optimisation et pour suivre la bonne santé de votre site en référencement naturel.

L’intérêt de l’analyse de logs n’est plus à prouver mais certains usages pourraient vous convaincre de vous lancer dans la pratique. L’analyse de logs SEO permet :

- De connaître les pages parcourues par Google sur votre site web

- D’analyser les catégories de votre site les plus performantes en SEO

- D’observer où Google se rend le plus souvent sur votre site (et donc ce qu’il apprécie)

- De connaître les problèmes bloquants liés au référencement naturel

- D’identifier les pages orphelines de la structure de votre site

- D’identifier l’impact du contenu dupliqué vis-à-vis de Google

- …

Récupérer ses logs sur un serveur mutualisé (Exemple chez OVH)

Quel que soit l’outil d’analyse de logs que vous utilisez, la partie la plus délicate va être de récupérer vos logs chez votre hébergeur. Mon site www.victor-lerat.fr est actuellement hébergé chez OVH sur un serveur mutualisé.

Pour récupérer vos logs sur OVH, rendez-vous à l’adresse : https://logs.ovh.net/votre-nom-de-domaine/

Pour ma part, cela donnerait : https://logs.ovh.net/victor-lerat.fr/

Sur cette page, vous allez vous retrouver face à différents types de fichier logs :

- Web = Log de votre site web (ceux qui vont nous intéresser pour l’analyse de logs SEO)

- FTP = Log de connexion à votre FTP (intéressant pour savoir si quelqu’un essaye de pirater votre FTP)

- Error = log d’erreurs rencontrées sur votre mutualisé (intéressant pour votre service technique)

- Out = log du trafic sortant sur le protocole TCP (utile pour vérifier que votre serveur ne sert pas à DDOS d’autres serveurs)

Du coup, pour analyser vos logs SEO, vous devez récupérer les logs contenus dans les archives « Web ». Sur Oncrawl, ces fichiers logs devront être importés sur un serveur FTP qui vous sera communiqué à l’avance par les équipes techniques de l’outil d’analyse de logs.

Petit astuce : pour récupérer l’ensemble des fichiers logs en un seul téléchargement, je vous invite à utiliser le plugin : DownThemAll.

Tour d’horizon des fonctionnalités offertes par OnCrawl

La solution OnCrawl est pour moi la solution la plus simple à appréhender et la moins chère du marché. OnCrawl propose des visualisations très graphiques et la prise en main de l’outil est très rapide.

Après avoir uploadé vos logs sur le serveur FTP, vous pourrez avoir accès à différents tableaux de bord :

- Crawl Behavior

- SEO Impact

- Exploration Sanity

- Logs Explorer

Crawl Behavior

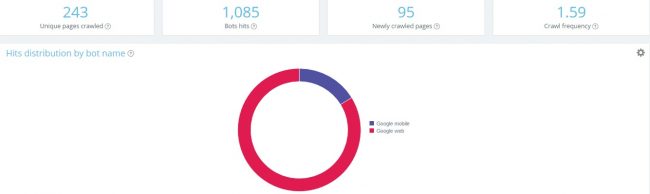

Ce premier volet permet de visualiser le comportement d’exploration des bots de Google sur votre site web. Dès cette première étape, vous pourrez connaître le nombre de pages, de nouvelles pages et le nombre de pages uniques crawlées par Google (ainsi que la moyenne des visites de Google sur vos pages internes).

Vous pourrez également observer la répartition des hits en fonction des robots de Google (Google Web ou Google Mobile).

Profitez de ce premier tableau pour vérifier si toutes vos catégories sont bien explorées sur votre site web. Plus vos pages sont crawlées par Google, plus vous avez de chances quelles soient appréciées par Google et donc bien positionnées sur son moteur de recherche.

SEO Impact

La partie SEO Impact permet d’avoir une idée des performances SEO de votre site Internet. Vérifiez vos pages actives (pages ayant généré au moins une visite depuis les moteurs de recherche) et interrogez-vous sur l’utilité des autres pages de votre site. Certaines seront à optimiser et les autres devront tout simplement être supprimées de votre site car elles n’apportent rien en référencement naturel.

Ce tableau de bord permet de comparer les visites SEO par groupe de pages. Sur mon site, la catégorie /referencement-naturel/ génère entre 10% et 40% des issues de Google. C’est d’ailleurs plutôt normal puisqu’il s’agit de la seule catégorie que j’ai « un peu » travaillé sur mon site web.

Exploration Sanity

Le troisième volet concerne la bonne santé de votre site. Les erreurs 404, 500 et les redirections 301 sont répertoriées dans cette partie de l’outil. Profitez-en pour nettoyer votre site et optimiser le crawl de Google. De mon point de vue, la plupart des erreurs peuvent être et doivent être corrigées avant l’analyse de log. Aurélien Bardon le soulignait d’ailleurs dans l’un de ses derniers articles de blog.

En éliminant chaque petite erreur, vous allégerez le crawl de Google qui pourra se concentrer sur des pages utiles en SEO et stratégiques pour votre activité !

Logs Explorer

Le volet « Logs Explorer » est un fichier Excel intelligent et dynamique en ligne. Toutes vos données logs sont à votre disposition et vous pourrez trier, filtrer et uploader les données qui vous intéressent pour optimiser le référencement de votre site web.

Dans le cas d’un petit site, c’est très puissant. On peut vite repérer les pages crawlées par Google et qui ne sont pas actives (c’est à dire qui ne génèrent aucune visite depuis Google). Sur mon site https://www.victor-lerat.fr j’ai remarqué que le Google Bot parcourait des pages inutiles (anciennes pages en php, anciennes pages qui répondent 404, etc.). Sans l’analyse de log, je n’aurai pas pu repérer ces pages.

Allez plus loin avec l’analyse croisée Crawl vs Logs

Oncrawl permet de croiser les données entre un crawl classique de votre site web, les données obtenus dans vos logs et même avec les statistiques Analytics de votre site web. Il est donc possible d’obtenir le taux de crawl et la fréquence de crawl de vos pages ou d’un groupe de page.

Sur un petit site web, si vos pages sont crawlées 2 fois par jour par le Google Bot, c’est déjà très bien ! Sur des sites médias, la fréquence de crawl doit être beaucoup plus importante pour que Google puisse repérer les mises à jour régulière sur le site.

Dans le cas de mon site avec la fonctionnalité « Logs cross analysis« , j’observe en un coup d’œil le ratio de crawl, le nombre de pages orphelines, le nombre de visites SEO sur les pages orphelines, les pages actives…

Pour nettoyer un site de petite taille, c’est l’idéal !

Avec l’analyse croisée, vous pourrez comparer le nombre de pages crawlées par Google et par groupe et le nombre de pages connues dans la structure. Par exemple, sur mon site et dans la partie « Référencement naturel« , Oncrawl m’indique que 18 pages ont été crawlées par Google alors que le crawl classique n’avait fait ressortir que 15 pages dans la structure. Trois pages ne semblent donc pas être rattachées convenablement à mon mini-cocon sur le référencement naturel.

Analysez la performance de votre site avec Google Analytics

Autre avantage de la solution Oncrawl, c’est qu’elle permet de croiser les données de crawl avec vos statistiques Analytics. Trois volets sont alors proposés :

- SEO Impact

- SMO Impact

- Users Behavior

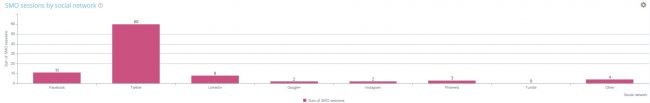

Les deux derniers volets sont vraiment très puissants. Le premier permet de mettre en avant le trafic généré par groupe de pages et par réseaux sociaux.

Dans mon cas, certaines pages ne génèrent aucun trafic SMO alors qu’elles pourraient facilement en générer avec 2/3 optimisations rapides et en partageant les pages les plus pertinentes sur mes comptes sociaux. Ce n’est pas grand chose mais je pourrais facilement doubler mon trafic SMO avec ces optimisations.

Le dernier volet est encore plus intéressant car il permet de mettre en exergue la performance de vos pages d’un point de vue « expérience utilisateur ». Analysez le taux de rebond de votre site par groupe de pages et observez le temps moyen d’une session en fonction d’une nombre de mots sur une page ou du temps de réponse de la page. Dans mon cas, les utilisateurs restent en moyenne 7’30 min sur une page quand le contenu contient plus de 1200 mots contre 1’01 min quand le contenu de la page est inférieur à 300 mots.

Les contenus longs, ce n’est pas que pour Google !

Vous l’aurez compris, j’adhère totalement à l’outil proposé par Oncrawl. Ce n’est pas un outil à mettre entre les mains d’un débutant en référencement mais c’est une aide très précieuse pour les consultants SEO qui maîtrisent déjà les basiques. La récolte de données permet de gagner un temps de fou sur vos prestations SEO. Contrairement à Screaming Frog, c’est un outil qui illustre les données sous forme de graphes et de courbes. Cela peut-être très utile pour expliquer certains aspects techniques du référencement à des clients novices ou réfractaires aux changements.

Pour échanger avec l’équipe OnCrawl :

- OnCrawl : https://twitter.com/OnCrawl_FR

- Emma Labrador : https://twitter.com/Emma_Labrador

- Erlé Alberton : https://twitter.com/cubilizer

- Lionel Kappelhoff : https://twitter.com/Lionel_KL

- François Goube : https://twitter.com/francoisgoube

Maintenant, c’est à vous de jouer !

Commentaires

11 réponses à “L’analyse de logs SEO sur des sites à faible volumétrie”

Très enrichissant comme article, merci our ces notions très indispensables dans le référencencement.

Très intéressant comme outil. Je pense que cette analyse aura certainement de l’impact pour le référencement et le SEO.

Merci d’indiquer si c’est un article sponsorisé, ce n’est pas clair.

Bonjour Julien,

Si je ne l’ai pas indiqué c’est que je n’ai pas été payé pour rédigé l’article. L’outil est vraiment canon, tu devrais essayer. Je suis bluffer par les 3 solutions couplées ensemble (Logs + Crawl + Données Analytics). Les rapports permettent de faire ressortir des éléments vraiment pertinents tant pour le SEO que pour l’expérience utilisateur. Même pour des sites à faible volumétrie, je trouve ça rentable de l’utiliser !

Pour des sites de lead par exemple, les rapports sur l’expérience utilisateur sont vraiment indispensables. J’adhère 100% à l’outil.

Salut Victor,

sur ma todolist, il y a écrit OnCrawl depuis un moment… Ton article est clair et motivant, ça va surement faire remonter la ligne oncrawl sur le dessus de la pile 😉

J’ai pu voir une démo, sur un de mes sites, avec Erlé Alberton au seo campus, vraiment sympa, et avec une mise en évidence en 5 minutes des quelques problèmes que j’avais a régler.

C’est la grande force de l’outil selon moi : le gain de temps sur la récupération et la mise en forme des données. Il ne te reste plus qu’à analyser et mettre des optimisations en face des erreurs observées !

Hello Victor,

J’ai lu ton article hier suite à ta notification et franchement comme tu l’imagines je n’aime ni la forme ni le fond 🙂

Même si je salue un article qui parle de oncrawl car c’est une excellente solution qui mérite d’être connue,

bof bof

Tu es en fait des tonnes à tel point que l’on dirait un article sponsorisé :/ comme le souligne Julien.

Concernant l’analyse de logs d’un site de 250 pages tournant sous wordpress je pense que cela est quasiment inutile. D’ailleurs tu n’as dû observer aucun impact sur le trafic suite à cela.

Cela n’est pas trop grave car tu es SEO et tu passes ton propre temps sur ton propre site.

Mais avec le budget d’un petit client (petit étant donné la taille du site) cela serait gaspiller un budget précieux.

En gros entre 1J d’analyse de logs et 1J d’ajout de contenu, j’irai toujours vers le contenu pour un petit site

Pour un site de 250 pages rarement mis à jour, savoir qu’une URL est crawlée 2 fois par jour, comment dire… cela m’en touche une sans toucher l’autre. Désolé je n’ai pas trouvé de meilleure expression 🙂

Cela n’est pas ce qui fera mieux ranker et augmenter le CA. A partir du moment où tes contenus sont indexées c’est déjà très bien.

Coupler crawl/analytics/log est vraiment puissant et j’adore cette méthodo sur les gros sites avec des URL immondes. Pour un petit wordpress c’est sortir le bazooka et gaspiller des munitions.

Bref, mauvaise strat à mon humble avis

Comme dis sur Twitter, on n’est pas dans un monde de bisounours donc ton commentaire, je l’accepte sur le fond et la forme.

J’avais testé Oncrawl en payant comme un grand sur une dizaine de sites (mode crawl uniquement). Je trouvais l’outil pertinent et sympa pour prouver au client par A + B qu’il fallait modifier certains éléments sur le site. Après, j’utilisais à 90% screaming frog pour l’ensemble de mes clients (ayant des petits sites). Cela me permet de corriger la majorité des erreurs sur les sites de petite taille.

Par contre avec la version Crawl + Logs + Analyics, les données sont beaucoup plus complètes et j’ai été vraiment bluffé (j’avais testé Botify à l’époque et les rendus étaient moins clairs pour moi). Ces données peuvent être pertinentes à intégrer à un audit et pour aller plus loin dans l’analyse et donc les optimisations.

J’aime à rendre les sites 100% clean pour plaire à Google. Pour moi, toutes les optimisations ont un impact sur le court ou le long terme. Il est donc important d’optimiser l’ensemble d’un site (même les petits aspects). Par ailleurs, Oncrawl en mode basique (tarif de base) propose un package « Analyse de Logs + Crawl » pour une dizaine de sites (utiles quand ton client à une dizaine de PETITs sites). Tu peux t’amuser à crawler chaque site, les nettoyer et mettre en place l’analyse de log sur le plus gros (+300 pages dans le cas de mon client).

Après, je suis d’accord avec toi à 200%, ce n’est pas le type de prestation que je vends à la pelle à mes clients ayant des petits sites. Comme dis plus haut :

1) Rendre le site clean (sans analyse de logs)

2) Contenu

3) Linking

4) Une fois que tout est OK, on peut passer à la vitesse supérieur en apportant les logs pour aller plus loin et optimiser le crawl de GG sur les pages stratégiques (et corriger les erreurs invisibles + revoir les contenus qui ne plaisent pas à Google et aux internautes)

J’espère que ce commentaire te paraîtra moins bullshit que la vision que tu as eu de mon article 😉

La évidement je suis 100% d’accord avec toi 😉

j’avais oublié, merci pour le BL même si j’ai l’air d’un ingrat pour le coup 😀

Bonjour,

J’ai découvert ton article hier soir sur twitter, effectivement ton article pousse un peu oncrawl (j’en suis utilisateur et c’est un tool très bien, dès qu’on est sur un site à fort volume c’est clairement pertinent).

Avant d’être sur gros site et pour se faire la main, il existe aussi le log analyser de screaming frog. Si ça t’intéresse j’ai fait un article (et une vidéo) sur le sujet il y a quelques jours. => https://www.valib.us/seo/optimisation-on-site/analyse-de-logs